|

Körperlose Musik? Die Internationale Computermusikkonferenz (ICMC) 2000 in Berlin von William Osborne und Abbie Conant MusikTexte Heft 86/87 – November 2000 Die Internationale Computermusik-Assoziation (ICMA) ist

eine akademische Organisation aus Komponisten, Interpreten, Ingenieuren und

Wissenschaftlern, die an der Anwendung digitaler Medien auf die Musik arbeiten.

Die Zusammensetzung ihrer Mitglieder ist international, und die Konferenzen

wechseln sich zwischen den Amerikas, Europa und Asien ab. Die jüngste wurde

vom 27. August bis zum 1. September in Berlin abgehalten und umfaßte zwölf

Konzerte mit neuer Musik (mit annähernd siebzig Kompositionen) und über

hundertdreißig Vorträgen, die auch in den 563 Seiten starken

„proceedings“, dem Kongreßbericht, veröffentlicht waren. Die

Veranstalter hatten darüber hinaus eine Compactdisc, die zehn der im Festival

aufgeführten Kompositionen

enthielt, produziert. Von morgens früh bis abends spät fanden oft zwei bis

vier Veranstaltungen gleichzeitig statt. Schließlich gab es ein

Zusatzprogramm im Berliner Podewil, das weitere Konzerte und eine Reihe

Workshops enthielt. Das Eröffnungskonzert bestand in einer der seltenen Aufführungen

von John Cages Komposition „HPSCHD“ (eines der ersten wichtigeren

Beispiele für Computermusik), die über fünfzig im Foyer der Berliner

Philharmonie [wo das Werk 1972 seine Uraufführung erlebte] installierte

Lautsprecher wiedergegeben wurde. Als diese anfingen, von überallher

metallische Flitter entkleideter Barock-Klänge abzustrahlen, entstand eine

andächtige Stille, aber schon nach wenigen Minuten begann das Publikum, das

in Gruppen herumstand, wieder zu reden und setzte seine Gespräche für die

einstündige Dauer der Aufführung fort. So blieb das Konzert eine ehrenwerte

Anstrengung, die vom Publikum nicht wirklich anerkannt wurde. Vielleicht ist

Musik, die aus Foyer-Lautsprechern kommt, zu allgegenwärtig geworden. Innerhalb der Konferenz gab es eine Reihe von Sitzungen

zum Thema „physical modeling“. Der Ansatz dabei ist, eine Software zu

entwickeln, die einen Instrumentalklang nicht nur nachahmen kann, sondern auch

seine akustischen Grundlagen und Besonderheiten in der Aufführung berücksichtigt.

So kann die eigene Qualität der Instrumente über elektrische Tastaturen

wiedergegeben werden – synthetische Klarinetten, die das Quieken von

schiefen Rohrblättern nachmachen können, oder den angespannten Luftdruck,

der bei Trompeten durch halb gedrückte Ventile oder Überblasen des Tons

entsteht. Forschungen im Ircam haben diese Modelle so weit perfektioniert, daß

sie fast so schwer zu spielen sind wie die akustischen Instrumente, die sie

ersetzen. Der nächste Schritt ist, Modelle für das Spiel bestimmter Musiker

zu entwickeln. Man könnte zum Beispiel einige von Coltranes Eigenarten des

Saxophonspiels digital simulieren. In achtzehn Sitzungen wurden konkrete neuere

Forschungsergebnisse vorgestellt. Adrian Freed vom Center for New Music and

Audio Technology an der University of California demonstrierte eine Tastatur,

die während des Niederdrückens oder Loslassens einer Taste ständig

Informationen über die Vorgänge liefert. Über eine Ethernet-Verbindung wird

das Gerät an ein Notebook angeschlossen und ermöglicht neben vielen anderen

Anwendungen die einer expressiveren und authentischeren digitalen Tastatur.

Perry Cook und Colby von der Princeton University stellten zwei „squeezeVoxes“

genannte, stark modifizierte Akkordeons vor, die durch die Instrumentenbälge

eine „physical-modeling“-Software steuern, mit der die menschliche Stimme

synthetisiert wird. Tomoko Yonezawa und Kenji Mase stellten einen

klavierspielenden Springbrunnen vor. Geschwindigkeit, Ambitus und Lautstärke

der Musik ändern sich dabei in Übereinstimmung mit dem Tröpfeln und Fließen

des Wassers durch seine Trichtern. Forscher an den Universitäten von Zürich und Campinas in

Brasilien stellten einen Roboter mit der Fähigkeit vor, Musik zu erfassen und

danach seine Erfahrungen zu reflektieren.

Er wurde programmiert, innerhalb eines eingegrenzten Gebiets nach

Lichtkegeln zu suchen und seine Bewegungen mit Musik zu begleiten. Durch

Herumstolpern konnte er feststellen, wo die Grenze war, was eine leise und

dissonante Musik zur Folge hatte, und wo die helleren Stellen waren, an denen

die Musik eine Oktav höher kletterte und erhabener wurde. Der Roboter, der

ungefähr acht Zentimeter groß war, hatte somit gewissermaßen ontologische

und epistemologische Eigenschaften. Sein Lernprozeß erzeugte eine

musikalische Struktur, die von der Frustration zur Transzendenz fortschritt,

da er mehr über deren Welt in Erfahrung bringen konnte und zum Licht strebte.

Epen der menschlichen Geschichte spielten sich vor unseren Augen ab. Es gab auch Schauplätze, an denen verschiedene Projekte

präsentiert wurden. Eines der bedeutendsten hatte Kristine H. Burns von der

Florida International University angeregt, die ihre Forschungen in bezug auf

Online-Pädigogik und ihre „wow’em“-Webseite diskutierte. Die schön

gestaltete und informative Seite ermutigt junge Leute, und besonders Mädchen,

mehr über Computermusik zu lernen. Weitere Forschungsgebiete umfaßten die Gestaltung

virtueller Musikräume, bewegungsempfindliche Installationen, dreidimensionale

Klangverräumlichung, Audio-Kodifizierung, Klangverarbeitung und -wahrnehmung,

Wandler und Lautsprecher, intelligente Kompositionswerkzeuge, tempo-empfindliche

Software und Klangsyntheseverfahren. Leider waren viele der Präsentionen fast

unverständlich, und zwar nicht deswegen, weil das Material (wie oft)

kompliziert war, sondern aufgrund der Präsentation selbst. Einer der attraktivsten Themenbereiche der

Computermusikkonferenz wurde in Sitzungen über die Ästhetik der

Computermusik behandelt, die teilweise von Leigh Landy organisiert waren. In

den Aufrufen zur Teilnahme an der Konferenz teilte der Veranstalter mit, daß

„Computermusik weder ein Stil noch eine Genre“ sei. Zwei

Musikwissenschaftler aus Dänemark meinten, daß die Computermusikkonferenz ästhetisch

vorbelastet sei. Sie orientiere sich an der „akademischen Computermusik“,

die sich ganz auf den abstrakten Klang konzentriere, der von den neueren

Technologie-Entwicklungen hervorgebracht werde. Ingeborg Okkels und

Anders Conrad glauben, daß diese „Ingenieur-Komponisten“ vor

anderen Gruppen bevorzugt werden, zum Beispiel vor denen, die der

amerikanischen Tradition der experimentellen Musik folgen (z.B. John Oswald und John

Zorn), die meistens technisch simple Geräte wie Sampler benutzen, um

kulturelle Artefakte zusammenzustellen. Indem sie auf die neueste Technologie

setzt, trifft die Computermusikkonferenz stillschweigend ästhetische

Entscheidungen. Es war offensichtlich, daß der Technologie manchmal ein höherer

Status beigemessen wurde als musikalischer Qualität und daß Komponisten

dadurch angestiftet wurden, ihre Werke als technologischer auszugeben als sie

wirklich sind. Die Computermusikkonferenz löscht damit ihre eigene Geschichte

aus, weil musikalisch wertvolle elektroakustische Werke, die ohne viel Technik

auskommen, kaum aufgeführt wurden. Ein Stück von Karlheinz Stockhausen zum

Beispiel, der ein enormes Vermächtnis hinsichtlich der elektroakustischen

Musik hinterlassen hat, wurde auf dieser Konferenz in Deutschland weder aufgeführt

noch war der Komponist selbst anwesend. Okkels und Conrad meinten, daß der

Preis, der für die Bevorzugung der „Inginiuer-Komponisten“ gezahlt würde,

der sei, „daß der ‘Ingenieur-Weg’ die Zuordnung der seriellen Musik zur

Experten-Kultur nur in die Computermusik hinein“ verlängere. Friedrich Kittler von der Humboldt-Universität in Berlin,

einer der weltweit anerkanntesten Medienhistoriker, diskutierte die Beziehung

zwischen Technologie und Krieg. Er gab seiner Auffassung Ausdruck, daß die

Computermusik aus dem gleichen Milieu kommt wie die „Männer in weißen

Kitteln“, die für den militärisch-industriellen Komplex arbeiten. Er regte

an, daß wir für unser eigenes Wohlbefinden mehr über die soziale Bedeutung

der Technologie und die „Ontologie der Denkmaschinen“ lernen müssen. Natasha Barrett, eine Engländerin, die in Norwegen lebt,

erläuterte ihre Methoden, kompositorische Strukturen auf natürliche Phänomene

zu beziehen, zum Beispiel auf mathematische Modelle von Lawinen oder die räumliche

Distribution von Tierlauten in tropischen Regenwäldern. Im Gegensatz dazu

sprach der Kanadier Barry Truax von der Fähigkeit des Computers, Formen eines

inneren Theaters darzustellen und zu schaffen. Da Computermusik eine sehr präzise

Klangkontrolle erlaube und keine Interpreten benötige, führe sie auf natürliche

Weise in eine innere Welt, die sehr real ist, einzig real im Gegensatz zur

Trickwelt der Virtuelle dreidimensionalen Realitäten, bei denen wir immer

daran denken, daß irgendwo im Hintergrund ein Computer anwesend ist. Obwohl fünf von neun Ästhetik-Vorträgen von Frauen

gehalten wurden, war an der großen Abschlußdiskussion, die von sechs weisen

Professoren bestritten wurde, keine Frau beteiligt. Wie auch immer die Zukunft

der Computermusik aussehen mag, scheint es, daß Frauen immer noch aus ihr

herausgehalten werden. Nur vierzig von 499 Mitgliedern der ICMA sind Frauen

– oder acht Prozent. Interessanterweise stammten siebzehn Prozent der auf

der Konferenz vorgestellten Kompositionen, die aus anonymen Einreichungen von

über sechshundert Bewerbern durch eine Jury ausgewählt wurden, von Frauen

– mehr als doppelt soviel, wie sie Mitglieder in der Organisation zählen. Unter den ausgewählten Kompositionen gab es zwei

Kategorien, von denen die eine ausschließlich elektroakustische Klänge und

die andere Elektronik mit Solisten oder kleinen Kammerbesetzungen zugrunde

legte, wobei etwa zwei Drittel klassische „Tonbänder“ und ein Drittel

eine Form von „interaktiver“ Elektronik – gewöhnlich mit den Programmen

MAX oder Super Collider geschrieben – verwendeten. Sowohl in der Matthäus Kirche als auch in der Akademie

der Künste, wo die Stücke aufgeführt wurden, waren ausgezeichnete oktophone

Anlagen installiert. Aufgrund der ästhetischen Orientierung des Programms gab

es keine Stücke für Ensembles von elektronischen Instrumenten, und nur sehr

wenige beschäftigten sich auch nur entfernt mit der Unterteilung einzelner

Tonhöhen und verschiedenen Ausprägungen metrischer Rhythmen. Im Zentrum

stand dagegen die klangfarbliche Gestaltung von Klängen. In der Tat gab es

eine Reihe von Komponisten mit wissenschaftlichem oder technischem Hintergrund,

die kaum eine „richtige“ musikalische Ausbildung genossen haben. Die Komposition „Voices Part II“ von Todor Todoroff

aus Belgien beschwor Erinnerungen aus seiner Kindheit, in der er kleine Radios

gebaut und gehört hat. Delikate sinusförmige Glissandi erinnerten an die

Sendersuche in alten Radios, während geisterhaft verrauschte Stimmen sich zu

enormen Rechteckschwingunen aufbauten. „Shatter“ von Marc Ainger aus den

USA beeindruckte durch die Emulation von zerbrechendem Glas und berstenden

Metallobjekten, die von den Klängen schwerer Maschinen begleitet wurden. Das

Stück baute sich zu einer „cyberdelischen“ Vision eines Metallfraßes

auf, außerirdische Termiten, die einen Müllplatz verheeren, aber der

Komponist wußte offensichtlich nicht ganz, wie er das Stück abschließen

sollte. Am Ende ging das geräuschvolle Kauen in einem rostigen Regensturm

unter. Dagegen war die „Music for Hi-Hat and Computer“ von Cort Lippe aus

den USA eines der wirkungsvollsten „interaktiven“ Stücke der Konferenz.

Aufgrund seiner reichen Obertonfülle kann das Becken sehr wirksam gefiltert,

in der Zeit gedehnt und klangfarblich wie -räumlich durch ein Programm der

Sprache MAX MSP vielfältig verändert werden. Das Stück hatte

improvisatorischen Charakter und war gegen Ende eher repetitiv. „Sotto/Sopra“

von Richard Karpen aus den USA war ein interaktives Stück für Violine und

Computer, das ähnliche Technologien verwendete und aufgrund seines

raffinierten Geigenparts, der von Iliana Göbel ausgezeichnet gespielt wurde,

bemerkenswert war. „Entropy“ von Christopher Dobrian aus den USA für

Disk-Klavier und Videoprojektion fiel deshalb auf, weil es eines der wenigen

Stücke war, das ausschließlich eine Reihe von zwölf Tonhöhen ohne

klangfarbliche Veränderungen verwendete. Das MAX-Programm erzeugte

faszinierende, von Menschenhand unspielbare Gesten, die über die Tastatur

fegten. „The Voice of The Phoenix“ von Gordon Monroe aaus Australian, für

Tonband und eine Kontrabaßflöte das sich von einem Stackel auf dem Fußboden

zur Größe von 1,80 Metern erhebt, bevor es sich wieder über ein riesiges

Dreieck wieder zum Mund des Interpreten zurückbiegt, war deshalb interessant,

weil das akustische Instrument viel exotischer war als die elektronischen Klänge,

die es umringten. Monroe, Professor der Mathematik, komponiert eine sehr

differenzierte Musik, auch wenn er – vielleicht in einem Übermaß an

Bescheidenheit – im Gespräch erwähnte, daß er nicht wüßte, wie man

einen verminderten Septakkord auflöst. Der deutsche Komponist Ludger Brümmer stellte zusammen

mit der Videokünstlerin Silke Brämer ein gut aufgenommenes und sehr

anspruchsvolles Werk für Videoprojektion und Lautsprecher vor, wobei er eine

Software benutzte, welche die Erzeugung von Klang und Videobildern aufeinander

bezieht. Francis Dhomont aus Kanada stellte eines der besten Werke

der ganzen Konferenz vor. Ausgehend von Samples verschiedener Flötentypen

stach es durch seine außerordentlich wohlproportionierte Form hervor, die

eine interessante Vielfalt subtil gearbeiteten Materials mit Sinn für

Spannung und Entspannung vereinte und vom Komponisten am Mischpult

eindrucksvoll verräumlicht wurde. Die ICMA hat keinen Fehler gemacht, als sie ihren

Kompositionsauftrag für diese Konferenz an Elizabeth Hoffmann aus den USA

vergeben hat. Ihre eindrucksvolle Stück „Manhattan Breakdown“ für

Klarinette, Violoncello, Schlagzeug, Tonband und Live-Elektronik untersuchte

Improvisationsstrukturen, die auf vorherbestimmten Elementen beruhen und eine

freie Zeitgestaltung zwischen der Aufführung und dem Tonband ermöglichen.

Die Arbeit zeigte das weite Spektrum der ihr zur Verfügung stehenden

kompositorischen Mittel. Gegen Ende der Konferenz wurde die Musik aufgrund der ästhetischen

Begrenzungen ihres Programmschemas eher voraussagbar. Der Eindruck von

Homogeneität kam auch deshalb zustande, weil viele die gleichen

Syntheseprogramme verwendeten – vor allem MAX und Super Collider. Diese

Programme sind sehr flexibel, aber das Komponieren mit „patches“[1] kann

ästhetische und epistemologische Vorlieben für bestimmte Arten von Klängen

und Effekten schaffen. Ein tusche-ähnliche Klangmaterial, erzeugt durch

stotternde „Granulation“[2], die durch gleitende, modulierende Klangfarben

gestaltet werden, war allgegenwärtig, genauso wie improvisierte Echtzeit-Verräumlichungen

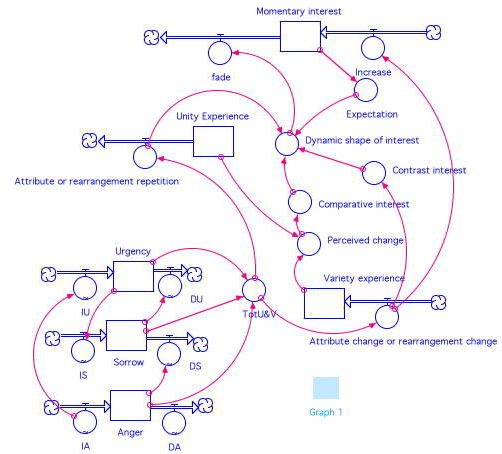

am Mischpult. Wenn es eine allgemeine Schwäche der Musik gab, lag sie in der Form. Klangfarbenstudien sind in der westlichen Musik relativ neu und daher gibt es für ihre Struktur nur wenige Vorbilder. Nachdem ihm dieses Problem schon in früheren Konferenzen aufgefallen war, machte Ian Whalley aus Neuseeland den Vorschlag, daß man System-Dynamik-Modelle benutzen könnte, um narrative Strukturen für die Computermusik zu erzeugen. [Siehe Abbildung.] Er demonstrierte diese Idee anhand computerisierter Flußdiagramme welche die Strukturen von Stücken wie Shakespeares „Hamlet“ wiedergaben.

Diagram courtesy of Ian Whalley

Probleme bleiben dennoch, weil man immer noch etwas

Semiotisches (Zeichen und Zeichengeber von metaphorischen Bedeutungen) braucht,

um die Strukturen zu bilden. Die Klangfarbe, die im Zentrum der meisten

Computermusik steht, wird nicht mit der gleichen Fülle an semiotischen

Bedeutungen assoziiert wie Tonhöhe oder Rhythmus. Die Gründe dafür mögen

nicht nur kultureller Natur sein, sondern haben auch etwas mit den kinästhetischen

Eigenschaften von Musik zu tun. Vielleicht der Wichtigste bleibenden Eindruck, den die

Konferenz hinterlassen konnte, war das Ausmaß, in dem der Computer die Musik

körperlos macht. In seinem Grußwort sagte Joel Chadabe: „Wir wollen ein

holistisches Instrument, das den Geist beansprucht und unabhängig vom Körper

ist. Wir können die Klänge einer ‘cityscape’ erzeugen. Wozu braucht man

dann noch einen Körper?“ Obwohl er nicht gegen den Körper ist, sprach er

von ihm als unnötiges Hindernis für das Musikmachen, eine Begrenzung für

die Freiheit des Geistes.

Einige glauben, daß dieser Ansatz auf falschen Annahmen,

was der Mensch sei, beruhen. In den letzten beiden Jahrzehnten haben kognitive

Psychologen wie George Lakoff vorgebracht, daß es keine cartesianische,

dualistische Leib-Seele-Lehre gäbe, die Geist und Körper in metaphysischem

Sinn getrennt sein läßt. Der Verstand ist nicht körperlos. Seine

eigentliche Struktur ist den Einzelheiten unserer Verkörperung entlehnt.

Philosophen wie John Dewy und Maurice Merleau-Ponty sehen den Körper ebenso

als untrennbar vom Verstand an, als eine erste Instanz, die alles gestaltet,

was wir meinen, denken, wissen und mitteilen. Wir können feststellen, daß es kein Schnellverfahren

gibt, den Körper in die Musik einzubringen, und dass wir ohne den langen,

existentiellen Prozeß das Instrument Leib und Seele zu vereinigen, die

kognitiven Strukturen abschwächen, welche das Wesen musikalischer Bedeutung

darstellen. Technische und ästhetische Strategien zur Lösung dieses Problems

werden die Zukunft der Computermusik bestimmen. Übersetzung: Gisela Gronemeyer [1] Ablietung

von “patchcord” -- ein Überbleibsel

aus Frühen Tagen, in denen die Module analoger Synthesizer durch Stecken von

Kablen auf einem Steckfeld miteinander verbunden wurden. [2] Schnelle

Widerholungen eines kurzen Samples zur Erzeugung eines kontinuierlichen Klangs.

|